Google Voice Search

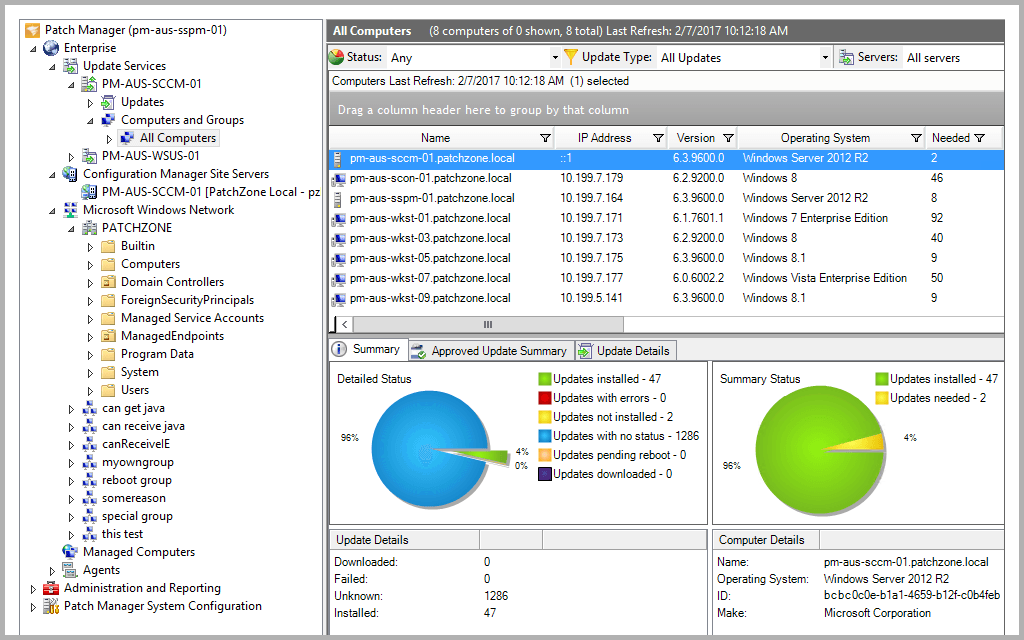

Google является одним из пионеров исследований в области искусственного интеллекта, и множество их проектов вскружили голову. AlphaZero от Google DeepMind команда стала прорывом в исследованиях ИИ благодаря способности программы самостоятельно изучать сложные игры (без обучения и вмешательства человека). Google также отлично поработал Программы обработки естественного языка (NLP), что является одной из причин эффективности Google Assistant в понимании и обработке человеческой речи.

Google недавно объявил о выпуске трех новых ИСПОЛЬЗУЙТЕ многоязычные модули и предоставить больше многоязычных моделей для получения семантически похожего текста.

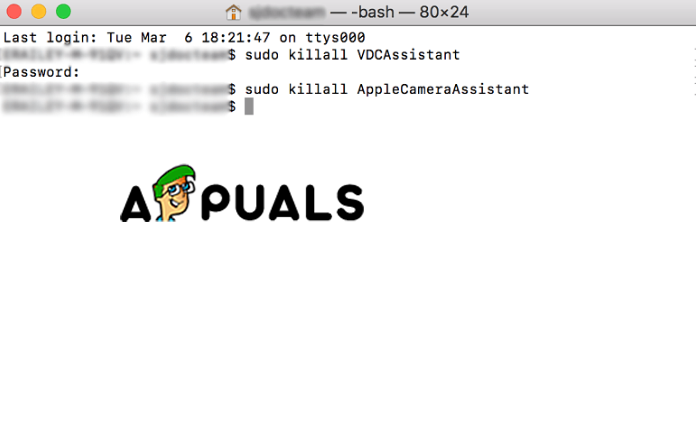

Первые два модуля предоставляют многоязычные модели для получения семантически похожего текста, один из которых оптимизирован для производительности поиска, а другой - для скорости и меньшего использования памяти. Третья модель предназначена для вопросно-ответный поиск на шестнадцати языках (USE-QA) и представляет собой совершенно новое приложение USE. Все три многоязычных модуля обучаются с использованием многозадачная структура двойного кодировщика , аналогичной исходной модели ЕГЭ для английского языка, но с использованием разработанных нами методик улучшения двойной энкодер с аддитивным запасом softmax . Они предназначены не только для поддержания хорошей производительности обучения передачи, но и для эффективного выполнения задач семантического поиска.

Обработка языка в системах прошла долгий путь, от синтаксического анализа дерева синтаксиса до больших векторных ассоциативных моделей. Понимание контекста в тексте - одна из самых больших проблем в области НЛП, и универсальный кодировщик предложений решает эту проблему, преобразовывая текст в многомерные векторы, что упрощает ранжирование и обозначение текста.

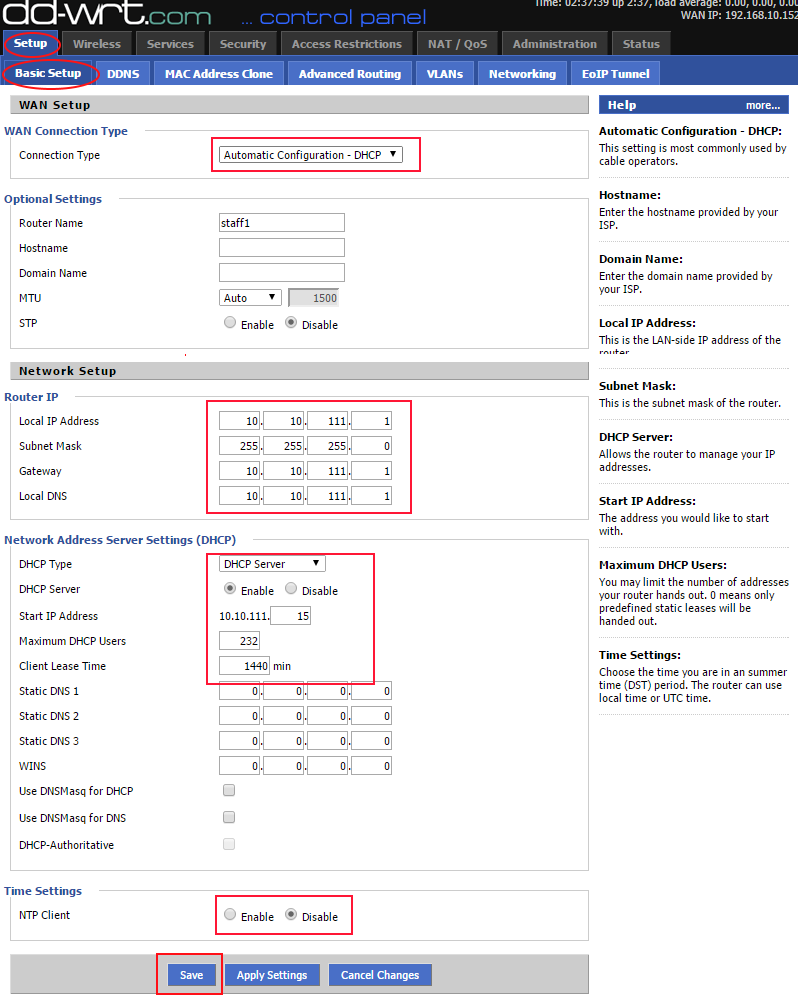

Источник структуры маркировки UTE - Блог Google

Согласно Google, « Все три новых модуля построены на архитектуре семантического поиска, которая обычно разделяет кодирование вопросов и ответов на отдельные нейронные сети, что позволяет осуществлять поиск среди миллиардов потенциальных ответов за миллисекунды. Другими словами, это помогает лучше индексировать данные.

' Все три многоязычных модуля обучаются с использованием многозадачная структура двойного кодировщика , аналогичной исходной модели ЕГЭ для английского языка, но с использованием разработанных нами методик улучшения двойной энкодер с аддитивным запасом softmax . Они предназначены не только для поддержания хорошей производительности обучения передачи, но и для эффективного выполнения задач семантического поиска. . » Функция Softmax часто используется для экономии вычислительной мощности путем возведения векторов в степень и последующего деления каждого элемента на сумму экспоненты.

Архитектура семантического поиска

«Все три новых модуля построены на архитектурах семантического поиска, которые обычно разделяют кодирование вопросов и ответов на отдельные нейронные сети, что позволяет выполнять поиск среди миллиардов потенциальных ответов за миллисекунды. Ключом к использованию двойных кодировщиков для эффективного семантического поиска является предварительное кодирование всех возможных ответов на ожидаемые входные запросы и сохранение их в векторной базе данных, оптимизированной для решения проблема ближайшего соседа , что позволяет быстро найти большое количество кандидатов с хорошими точность и отзыв . '

Вы можете скачать эти модули с TensorFlow Hub. Для дальнейшего чтения см. Полный текст GoogleAI Сообщение блога .

Теги гугл